mercoledì 30 luglio 2008

La Tenda Rossa

Achille e la tartaruga: soluzione

I greci non conoscevano il concetto matematico di infinito come lo conosciamo noi oggi.

I greci non conoscevano il concetto matematico di infinito come lo conosciamo noi oggi.

La tartaruga dice ad Achille: "mentre tu percorri 10 m io ne avrò comunque percorsi 5; mentre tu ne percorri 5 m io ne avrò comunque percorsi 2,5; mentre tu percorri 2,5 m io ne avrò percorsi 1,25" , e così all'infinito.

In realtà il paradosso sta nel fatto che gli infiniti spazi che dividono Achille dalla tartaruga sono sempre più piccoli e quindi sommati fra loro non danno un numero infinitamente grande: prima o poi arriva il momento in cui Achille sorpassa la tartaruga. I greci invece pensavano: una somma di infiniti numeri da sempre come risultato un numero infinito. Questo non è vero se i numeri della somma sono sempre più piccoli (si avvicinano man mano allo zero).

Un esempio numerico ci aiuta.

Se Achille corre alla velocità di 2 metri al secondo in 10 secondi avrà percorso 20 metri

La tartaruga che corre alla velocità di 1 metro al secondo in 10 secondi avrà percorso 10 metri. Aveva 10 metri di vantaggio su Achille e quindi in 10 secondi è già stata raggiunta.

sabato 26 luglio 2008

Storia della Apple

Mi pare che uno dei post più apprezzati sia stato quello sulla storia della Nokia. Oggi vi propongo una storia ancora più appassionante: quella della Apple e del suo fondatore Steve Jobs. Ho sintetizzato molto ma è ancora un po' lunga, ma d'estate c'è tempo per leggere.

Mi pare che uno dei post più apprezzati sia stato quello sulla storia della Nokia. Oggi vi propongo una storia ancora più appassionante: quella della Apple e del suo fondatore Steve Jobs. Ho sintetizzato molto ma è ancora un po' lunga, ma d'estate c'è tempo per leggere.

Apple Computer è stata creata il 1° aprile 1970. I soci fondatori, Stephen Wozniak e Steve Jobs, erano stati compagni di liceo agli inizi degli anni '70 ed avevano continuato a sentirsi anche dopo la scuola. Entrambi furono assunti da Società della Silicon Vally che operavano nel settore informatico. Wozniak era impiegato presso HP mentre Jobs lavorava per la Atari.

Fin dall'inizio, Wozniak aveva rivelato una spiccata propensione per i computer e per hobby iniziò un progetto destinato a diventare il primo prodotto di Apple battezzato, con molta poco originalità, Apple I. Ma il grande merito di trasformare un hobby in un affare fu di Steve Jobs. Apple I in realtà era solo una scheda elettronica: gli acquirenti per ottenere il computer funzionante dovevano aggiungervi un alimentatore, la tastiera, il display e un case (si legge cheis ed è il contenitore). La Bit Shop, la prima catena americana di informatica, ordinò 50 Apple I al prezzo di $500, ma i computer dovevano essere completi di tutto. Questa richiesta stravolse le idee iniziali dei fondatori di Apple che avevano infatti pensato di produrre esclusivamente le schede logiche, lasciando agli acquirenti il compito di assemblare il tutto. Nel garage dei genitori di Jobs preve il via questa avventura.

Jobs galvanizzato da questo primo ordine consistente chiese aiuto al suo capo in HP che gli fece conoscere le persone giuste per avere accesso ai capitali necessari all’espansione dell’impresa. Nel 1977 fu presentato l'Apple II, un'evoluzione del precedente progetto: il computer era in grado di gestire grafica a colori, una vera e propria rivoluzione per quel periodo. Anche la RAM era cresciuta, "ben" 12Kb (oggi la RAM è di 3Gb, 250.000 volte superiore). L'Apple II vendette oltre un milione di unità. Fu molto apprezzato perché era il primo computer a gestire un foglio di calcolo (l’antenato di excel).

L’Apple III non ebbe lo stesso successo non era stato progettato bene. Nonostante la RAM fosse stata aumentata fino a 128 Kb, non era stata prevista la ventola di raffreddamento e il case era troppo piccolo: il computer si scaldava e si guasta velocemente. Il danno di immagine per l’azienda fu consistente. Toccava al successore, il mitico Macintosh, far dimenticarel’insuccesso di Apple III.

La Xerox aveva in quegli anni inventato una macchina con una grafica per noi comune ma a quel tempo rivoluzionaria: aveva introdotto le icone, la barra dei menù, e un aggeggio con tre tasti chiamato mouse. Le azioni Apple andavano bene e Jobs e compagni permisero alla Xerox l’acquisto di 1 milione di $ in azioni: in cambio la Xerox aprì i propri laboratori agli ingegneri Apple che si impossessarono immediatamente delle novità.

Il rivoluzionario Macintosh, forma compatta, piccolo monitor integrato, in realtà non nasce da un’idea di Jobs ma da un collaboratore. Solo in seguito Jobs entrò nel progetto e per far valere le proprie capacità se ne impossessò: assunse decine di nuove persone pronte a dedicarsi anima e corpo al nuovo progetto. Ben presto l'intero team si rese conto che la IBM con il suo nuovo PC stava erodendo sempre più la supremazia di Apple. I membri del team lavoravano a ritmo continuo senza concedersi una minima pausa, e questo solo per riuscire a realizzare quello che per tutti loro era un vero e proprio sogno. Il Macintosh venne presentato il 24 gennaio 1984 alla riunione annuale dei soci Apple e venne accolto con grande entusiasmo. ll piccolo Mac era equipaggiato con un processore Motorola 68000 a 7,83MHz, aveva 128KB di RAM, un monitor monocromatico da 9 pollici (piccolo) e un design davvero accattivante.

Gli anni che seguirono il lancio del Macintosh furono animati e pieni di eventi che segnarono indelebilmente la storia di Apple; Jobs era consapevole che il Macintosh avrebbe avuto un futuro roseo solo se avesse garantito agli utenti un adeguato apporto di nuovi software. Già a quel tempo un tale Bill Gates era a capo di Microsoft, una delle realtà informatiche più stabili e affermate dell'epoca, nonché uno dei maggiori produttori di software esistenti. Per questo motivo, quindi, Jobs fu praticamente costretto a venire a patti con Gates per garantire una sufficiente produzione di software. Quello che Gates fece fu di studiare attentamente il Macintosh, ma per iniziare a pensare a un proprio progetto di sistema operativo che potesse mettersi in competizione con quello del computer di Apple. Il capo di Microsoft fu assolutamente perfido con Jobs e soci: da un lato faceva la parte dell'amico, socio in affari, dedicatosi anima e corpo alla causa del Macintosh; dall'altro progettava in gran segreto il proprio asso nella manica, Microsoft Windows.

Quando il nuovo sistema operativo di Gates fu pronto, prima di lanciarlo ufficialmente, questi riuscì a scendere a patti con Apple, ottenendo di evitare qualsiasi causa legale per l'evidente attività di plagio operata da Microsoft nei confronti di Apple. Apple consentì a Gates di utilizzare parti della tecnologia di Apple in cambio del continuo supporto a Word e della pubblicazione di Excel prima per Mac e in seguito per PC. E questo fu il primo grande errore.

La versione 1.0 di Microsoft Windows debuttò il 20 novembre 1985 e, sebbene le speranze di Gates fossero molte, il nuovo sistema operativo non riscosse particolare successo nel mondo informatico. Microsoft non si diede per vinta e continuò a sviluppare il proprio sistema operativo mentre nel frattempo produceva la nuova versione di Word ed Excel per Macintosh. Windows 2.03 debuttò nel gennaio del 1988, e questa volta le somiglianze con il sistema operativo di Apple furono talmente evidenti che i soci di Cupertino decisero di portare in tribunale Bill Gates & C. accusando Microsoft di aver violato l'accordo concluso in passato, poiché le concessioni in esso presenti erano valide solo per la versione 1.0 di Windows. L'excursus legale fu lungo e tortuoso e nei vari gradi di giudizio, i giudici interpellati si espressero alla fine a favore di Microsoft. La vicenda legale tra Apple e Microsoft era comunque irrilevante dato che ormai il sistema operativo di Microsoft dominava completamente il mercato grazie all'incredibile penetrazione avutasi con Windows 3.1 e successivamente con Windows 95. Il segreto? I PC attrezzati con windows costavano molto meno del Macintosh. Inoltre Bill Gates aveva strappato alla IBM, il più grande produttore di PC, un accordo incredibile: ogni PC che usciva pagava la licenza Windows. IBM non aveva interesse a montare altri sistemi operativi, anche se ce n'erano in circolazione e forse anche di migliori.

A questo punto iniziano anche le disavventure di Jobs all’interno di Apple: quando il successo del Macintosh inizia a calare, Jobs viene messo in minoranza all’interno dell’azienda e vengono sollevati dubbi sulle proprie capacità manageriali. E questo fu il secondo grande errore. Jobs il 17 settembre 1985 presentò le proprie dimissioni. Inizia un periodo grigio per Apple che arrivò vicino al fallimento.

Nel 1987 Apple introdusse sul mercato il Mac II, il primo computer in grado di visualizzare e gestire colori sul monitor. Equipaggiato con un processore Motorola 68020, il Mac II ebbe un successo più che discreto e Apple riuscì a tornare sulla cresta dell'onda. Ma l'ombra minacciosa di Windows si faceva sempre più densa e i PC compatibili provenienti dall’Asia conquistavano una fetta sempre maggiore di mercato. Apple iniziava a sentirsi in difficoltà e per la prima volta cominciarono a circolare idee e proposte che avrebbero visto la propria concreta attuazione qualche anno dopo: si pensò di concedere in licenza il sistema del Macintosh (cioè utilizzabile anche da altre aziende), e di rendere il proprio sistema compatibile con i PC attrezzati con processori lntel.

I primi anni '90 saranno da tutti ricordati come quelli della grande crisi per Apple, ma anche come gli anni in cui due progetti di particolare interesse videro la luce: il primo PowerBook e il Newton ossia il padre di tutti i palmari (progetto tuttavia sfortunato sia per carenze tecniche e probabilmente perchè troppo in anticipo sui tempi).

Il settembre del 1996 è un passaggio ancora importante nella storia di Apple. Jobs, se n’era andato 11 anni prima e aveva fondato una propria azienda, la NeXT, con l’intento di creare un nuovo computer e un nuovo sistema operativo. La Apple decide di acquistare la NeXT di Steve Jobs e quindi farlo rientrare. La notizie è accolta con esultanzadal popolo Apple. La prima mossa importante di Jobs è un accordo con l'acerrima nemica Microsoft, la Società di Bill Gates. In cambio dell'acquisto di 150 milioni di azioni Microsoft avrebbe garantito il continuo sviluppo del suo pacchetto Office per Mac per gli anni a venire. La seconda mossa fu l’annullamento degli accordi di licenza che permetteva ad altre società di produrre computer con sistema Apple. Il 1998 fu un anno grandioso per Apple, che iniziò la sua ripresa. Jobs annunciò l'intenzione di cambiare il modo in cui la società vendeva i propri prodotti. Nacque così l'Apple Store, che in un battibaleno sbalordì l'intero mondo economico per gli incredibili risultati ottenuti. Le cose stavano tornando a funzionare alla grande e Jobs si crogiolava nel suo personale successo. Apple continuava a fare profitti e il valore delle azioni saliva, raggiungendo i massimi storici. Nel 1999 venne introdotto l'iBook, con l'intenzione di conquistare anche il mercato dei computer portatili.

I primi anni del 2000 sono caratterizzati dal “mito dei megahertz”, della velocità. Intel e AMD (che fornisco i componenti ai PC) iniziano la corsa verso il chip da 1GHz, mentre Apple è ferma a 500MHz perchè Motorola non vuole o non può sviluppare ulteriormente il G4. Ad ottobre del 2002 Steve Jobs presenta un prodotto che rivoluzionerà il modo di ascoltare la musica: l’iPod. Nell’agosto del 2003 viene commercializzato il Power Mac G5 2.0GHz dual processor, ed il Mac torna ad essere il computer più veloce del mondo.

Siamo ai giorni nostri: Apple naviga alla grande, grazie al proprio spirito innovativo. Prodotti come l'iPod, i Mac Intel, il nuovo iTunes Store, le suite di software iLife e iWork, lo straordinario iPhone hanno consentito alla società di Cupertino di guadagnare una notorietà impensabile fino a poco tempo prima, anche al di fuori dell'ambito strettamente informatico. Steve Jobs resta saldamente al comando di Apple e, mai come ora, la società viene identificata direttamente con la sua persona. Non sembra potervi più essere una Apple senza Jobs e, allo stesso tempo, nessuno osa pensare a Jobs senza Apple.

sabato 19 luglio 2008

Achille e la Tartaruga

- Scommettiamo che riesco a batterti nella corsa anche se ti dò dieci metri di vantaggio ?

la tartaruga risponde:

- Sai, io sono molto lenta, è il mio stile di vita, ma se mi dai dieci metri di vantaggio, non puoi battermi!

- Sì che posso, io sono il doppio più veloce di te.

- Anche se sei il doppio più veloce non potrai mai raggiungermi. Vedi, mentre tu percorri i dieci metri che io ho di vantaggio io mi sposto in avanti di cinque. Tu dovrai poi percorrere questi cinque metri, ma io mi sarò spostata in avanti di altri due metri e mezzo che tu dovrai recuperare. Ma mentre tu cercherai di raggiungermi facendo questi due metri e mezzo io mi sarò spostata di un altro metro e venticinque e così via fino all'infinito, così tu non potrai mai raggiungermi.

Così dicendo la tartaruga tracciò sulla terra un diagramma che spiegava la situazione. Achille osservò a lungo il diagramma, ripetendo mentalmente più volte il percorso della gara, non riuscendo a capacitarsi di come fosse possibile che egli non riuscisse mai a raggiungere il più lento animale. D'altronde Achille poteva, ragionando in altro modo, sostenere di poter vincere la gara. Infatti quando Achille avesse percorso, diciamo, trenta metri, la Tartaruga ne avrebbe percorsi solo quindici; detratti i dieci metri di vantaggio iniziali, Achille si sarebbe ancora trovato in vantaggio di cinque metri. Il paradosso appassionò molto gli antichi che, non possedendo le nostre conoscenze matematiche, trovavano inspiegabile il ragionamento.

Provate a dare una risposta voi al paradosso.

Quadrato Lo Shu

Il quadrato Lo Shu è un quadrato magico normale di ordine 3, cioè una matrice di aspetto 3 × 3 contenente tutti gli interi da 1 a 9 senza ripetizioni disposti in modo tale che sommando i numeri sulle diverse righe, colonne o diagonali si ottenga sempre lo stesso valore, che deve essere (1+2+...+9)/3 = 15.

Il quadrato Lo Shu è un quadrato magico normale di ordine 3, cioè una matrice di aspetto 3 × 3 contenente tutti gli interi da 1 a 9 senza ripetizioni disposti in modo tale che sommando i numeri sulle diverse righe, colonne o diagonali si ottenga sempre lo stesso valore, che deve essere (1+2+...+9)/3 = 15.

Esso è originario della Cina. Una delle leggende che lo riguardano dice che intorno al 2800 AC si ebbe una disastrosa piena del fiume Lo causata dall'ira del dio del fiume e che la popolazione offrì dei sacrifici al dio per far cessare il disastroso evento. Dopo ogni sacrificio dal fiume emergeva una tartaruga, ma la furia del fiume non si placava. Solo dopo vari tentativi un bambino si accorse che la tartaruga inviata dal dio aveva segnata sul guscio una rappresentazione del quadrato magico. Questo significava che il dio chiedeva un sacrificio di 15 entità e l'accoglimento del messaggio portò alla fine della piena.

Questa configurazione è stata considerata un simbolo dell'armonia universale: i numeri da 1 (l'inizio di tutte le cosa) a 9 (il completamento) sono considerati benauguranti, soprattutto il 5 centrale. La somma magica 15 si interpreta come la durata di ciascuno dei 24 cicli dell'anno solare cinese; l'alternarsi dei numeri pari e dispari sulle caselle periferiche si interpreta come alternarsi armonioso di yang e yin. Nell'antica Cina ci si ispirava a questo quadrato per progettare templi e città suddivise in 3 × 3 settori.

Vediamo alcune proprietà aritmetiche di questo quadrato. Il numero centrale, il 5, è la media aritmetica di tutte le coppie di numeri opposti: (1+9)/2=5 , (8+2)/2=5 , (3+7)/2=5

Se si moltiplica il numero centrale 5 per l’ordine del quadrato, cioè 3, si ottiene il valore della somma costante, cioè 15.

I quadrati magici giunsero in Europa relativamente tardi (fra il 1200 e il 1300). Molti quadrati magici si supponevano dotati di virtù magiche particolari, e incisi su piastrine d’argento o d’oro, venivano consigliati come cura per ogni malanno, dalla peste al mal d’amore.

giovedì 17 luglio 2008

Ritorno al Nucleare? (2)

Negli ultimi tempi abbiamo assistito ad un costante aumento del prezzo del petrolio e molti commentatori hanno sostenuto che, di fronte al progressivo esaurirsi delle risorse petrolifere, il ricorso all’energia nucleare è inevitabile. Il caso della Francia è, a questo proposito, illuminante in quanto essa produce il 78% dell’energia elettrica da fonte nucleare. Bene, la Francia è al contempo al dodicesimo posto nel mondo per consumo di petrolio e al sesto posto nel mondo per importazioni di petrolio. La Francia consuma e importa più petrolio dell’Italia che non produce un singolo chilowattora da nucleare. Nonostante tutta la sua energia nucleare, la Francia consuma ogni giorno una quantità di petrolio equivalente all’intera produzione irachena. La credenza che il nucleare permette di liberarsi dal petrolio è dunque oggettivamente falsa ed il motivo è ovvio: chiunque abbia frequentato una buona scuola dell’obbligo sa che l’elettricità è solo una delle forme di energia possibili. Dalla fonte nucleare si produce energia elettrica ma il sistema dei trasporti è quasi interamente dipendente dalla fonte petrolifera. Uranio e petrolio servono comparti distinti e così sarà almeno fino al giorno in cui l’intero sistema dei trasporti, auto incluse, non sarà elettrificato. Ma se quel giorno verrà, non appena saranno disponibili auto elettriche con batterie a prezzi ragionevoli e dotate di sufficiente autonomia allora sarà (almeno per me) naturale caricare la batteria con l’energia solare autoprodotta in giardino senza bisogno di ricorrere a mega impianti nucleari dislocati a centinaia di chilometri di distanza ed alimentati con uranio dal ciclo produttivo ambientalmente ed economicamente insostenibile.

Negli ultimi tempi abbiamo assistito ad un costante aumento del prezzo del petrolio e molti commentatori hanno sostenuto che, di fronte al progressivo esaurirsi delle risorse petrolifere, il ricorso all’energia nucleare è inevitabile. Il caso della Francia è, a questo proposito, illuminante in quanto essa produce il 78% dell’energia elettrica da fonte nucleare. Bene, la Francia è al contempo al dodicesimo posto nel mondo per consumo di petrolio e al sesto posto nel mondo per importazioni di petrolio. La Francia consuma e importa più petrolio dell’Italia che non produce un singolo chilowattora da nucleare. Nonostante tutta la sua energia nucleare, la Francia consuma ogni giorno una quantità di petrolio equivalente all’intera produzione irachena. La credenza che il nucleare permette di liberarsi dal petrolio è dunque oggettivamente falsa ed il motivo è ovvio: chiunque abbia frequentato una buona scuola dell’obbligo sa che l’elettricità è solo una delle forme di energia possibili. Dalla fonte nucleare si produce energia elettrica ma il sistema dei trasporti è quasi interamente dipendente dalla fonte petrolifera. Uranio e petrolio servono comparti distinti e così sarà almeno fino al giorno in cui l’intero sistema dei trasporti, auto incluse, non sarà elettrificato. Ma se quel giorno verrà, non appena saranno disponibili auto elettriche con batterie a prezzi ragionevoli e dotate di sufficiente autonomia allora sarà (almeno per me) naturale caricare la batteria con l’energia solare autoprodotta in giardino senza bisogno di ricorrere a mega impianti nucleari dislocati a centinaia di chilometri di distanza ed alimentati con uranio dal ciclo produttivo ambientalmente ed economicamente insostenibile.

Veniamo così ad uno degli aspetti chiave della questione energetica. Se i reattori nucleari servono a produrre elettricità converrà dare uno sguardo alla composizione dei reali consumi elettrici odierni. In Europa, il settore residenziale e i servizi assorbono circa il 54% dell’elettricità totale mentre all’industria va una quota del 42% . Case e uffici incidono dunque non poco sul consumo elettrico complessivo. Focalizzando sui consumi residenziali si nota che le voci più energivore sono nell’ordine: sistemi di riscaldamento elettrici, sistemi di refrigerazione/climatizzazione, illuminazione e boiler elettrici. Insieme fanno il 58% dei consumi elettrici residenziali. Analogo è il trend per gli uffici. Qui il risparmio energetico e l’introduzione di input intelligenti nelle tecniche di costruzione possono abbattere drasticamente i consumi termo-elettrici mentre la parte di fabbisogno residuale può essere in gran parte coperta dalle tecnologie solari. In particolare, il solare termico è una tecnologia semplice, consolidata ed economica che permette in gran parte d’Italia e d’Europa di scaldare l’acqua per buona parte dell’anno a fini sanitari e di riscaldamento. Quando il sole non splende è facile integrare il fabbisogno mediante qualche pezzo di legna proveniente dalla manutenzione dei boschi. Eppure ancora il 9% del consumo elettrico residenziale viene mangiato dagli scaldabagno mentre il 22% se ne va per scaldare le stanze. Già tagliando solo queste due voci di consumo assurde si risparmierebbe una quantità di energia elettrica quasi pari a quella che l’Italia importa dalla Francia e che là è prodotta tramite i reattori nucleari. E la lista dei possibili risparmi potrebbe continuare a lungo. Vien fatto di chiedersi se sia veramente il caso di andare a scavare nelle miniere di Australia e Niger, estrarre l’uranio, triturarlo, gassificarlo, centrifugarlo, trasportarlo fino ad un reattore, innescare processi nucleari altamente energetici al fine di produrre elettricità, la quale a sua volta deve essere trasportata a lunga distanza ed infine, in case ed uffici, degradata in energia termica. Il tutto per farsi una doccia a 40 gradi centigradi o per scaldare una stanza a 18 gradi. Ad ogni passaggio di stato energetico corrisponde un processo dissipativo, dunque l’efficienza dell’intero processo produttivo crolla. Osservando le tipologie di consumo umane non si può non rilevare l’assurdo termodinamico. Il buon senso insegna che l’energia solare ha già un volto termico dunque per lavarsi e scaldarsi è, a queste latitudini, sufficiente quella per quasi tutto l’anno.

Razionalizzare i consumi non significa dover tirare la cinghia bensì aumentare la qualità della vita. Mangiar troppo e sprecare metà delle porzioni non significa mangiar bene, significa semplicemente appesantire il fisico e danneggiare l’ambiente.

In conclusione, tutti gli argomenti generalmente addotti in favore dell’uso dell’energia nucleare al fine della produzione elettrica sono stati smontati. I reattori nucleari non aumenteranno a livello mondiale la loro capacità produttiva globale per motivi intrinseci legati alla reperibilità dell’uranio e per gli alti costi dell’intero ciclo produttivo. In esso vanno inclusi ovviamente anche il processo di decommissionamento e lo stoccaggio delle scorie radioattive. La tecnologia nucleare nota ad oggi è semplicemente non conveniente per sopperire al fabbisogno di energia elettrica. Per questo motivo le previsioni di sviluppo avanzate negli anni ’60 e ’70 del secolo scorso sono regolarmente fallite. E’ anche bene chiarire che i famosi Reattori di Quarta Generazione (spesso citati con troppa euforia) non saranno comunque pronti prima del 2030 secondo le stesse dichiarazioni contenute nella Technology Roadmap delle 10 nazioni facenti parte del Generation IV International Forum. Quindi è possibile che si slitti verso il 2050.

Il reattore nucleare, di qualsivoglia generazione, è in realtà figlio di un’idea destinata a morire. L’idea fondamentale su cui si basa la tecnologia nucleare è quella della separazione tra luogo della produzione e luogo del consumo energetico. La mega-centrale (sia nucleare che a combustibili fossili) è necessariamente dislocata lontano dall’utente. Su questa idea è nata cent’anni fa e si è poi strutturata quella costruzione straordinaria che è la rete elettrica. Oggi però le tecnologie solari, per quanto ancora incentivate, già permettono di ricomporre la frattura tra produttore e consumatore d’energia e inducono dunque a ripensare l’intera struttura della rete. Senza alcun dubbio le società del futuro vivranno grazie all’energia solare che è inesauribile, non monopolizzabile ed utilizzabile in modo diffuso. Si tratta di capire quanto sarà lungo e problematico il processo di transizione all’economia solare. In questa direzione sensata sarebbe bene, fin da ora, impiegare i quattrini disponibili.

Fonte: Marco Zoli

martedì 15 luglio 2008

Ritorno al Nucleare? (1)

Si è riaperto in Italia il dibattito sull’opportunità di costruire reattori nucleari al fine di produrre energia elettrica e, al momento, sembra diffondersi nell’opinione pubblica l’idea che la scelta nucleare sia inevitabile. Conviene pertanto considerare alcuni elementi fondamentali e vincolanti della questione nucleare.

Si è riaperto in Italia il dibattito sull’opportunità di costruire reattori nucleari al fine di produrre energia elettrica e, al momento, sembra diffondersi nell’opinione pubblica l’idea che la scelta nucleare sia inevitabile. Conviene pertanto considerare alcuni elementi fondamentali e vincolanti della questione nucleare. Secondo i dati pubblicati dalla World Nuclear Association, aggiornati a Marzo 2008, esistono nel mondo 439 reattori nucleari (per una potenza complessiva di 372 GigaWatt) che producono il 16% dell’energia elettrica totale consumata dagli umani. La costruzione della maggior parte dei reattori è iniziata tra il 1965 e il 1975 e, nel 1985, si è raggiunto il massimo di nuova potenza nucleare connessa alla rete elettrica. Dunque, il tempo medio per la costruzione di un reattore è stato finora di circa 10 anni. Dopo del 1985 la potenza complessiva dei nuovi reattori entrati in esercizio è diminuita in modo significativo e così tutte le previsioni di forte crescita del settore nucleare fatte (a partire dal 1975) da International Atomic Energy Agency e Nuclear Energy Agency sono state poi smentite e corrette al ribasso. Attualmente ci sono 35 reattori in costruzione (e per alcuni, i cantieri sono già aperti da diversi anni) che forniranno una potenza complessiva di circa 29 GW ma, al contempo, va osservato che circa il 70% dei reattori esistenti sta invecchiando e dovrà essere mandato a riposo (decommissionato) entro i prossimi 25 anni. Le nuove costruzioni e quelle programmate potranno al più sostituire la potenza nucleare attualmente in esercizio ma, ad esser realisti, non è prevedibile un boom di nuovi reattori nei prossimi anni e dunque la percentuale di energia elettrica di origine nucleare rimarrà dapprima stazionaria e tenderà in futuro a calare.

I complicati iter burocratici e decisionali, gli ingenti costi di costruzione dei reattori, la necessità di garantire profili di sicurezza sempre più elevati in un mondo sempre più insicuro, la questione non risolta del trattamento delle scorie radioattive, sono tutti fattori che non incoraggiano gli investimenti nella tecnologia nucleare ai fini della produzione di elettricità. Vi è però un aspetto almeno tanto rilevante quanto quelli citati eppur tuttavia spesso non considerato a dovere: si tratta della disponibilità delle risorse di Uranio, l’elemento combustibile dei reattori attualmente in funzione. Ad oggi undici nazioni, tra le quali Germania, Francia e Repubblica Ceca, hanno esaurito le loro riserve e 2.3 milioni di tonnellate (ton) di uranio sono già state consumate. La domanda mondiale di uranio è di circa 67 mila ton per anno mentre la produzione si attesta sulle 42 mila ton. Così 25 mila ton sono prelevate ogni anno dalle scorte secondarie accumulatesi prima del 1980, nei tempi in cui la produzione di uranio era stimolata dalla domanda militare. Per quanto l’entità precisa di queste scorte secondarie non sia nota, si stima con le dovute cautele che esse si esauriranno in una decina d’anni. Allora già si pone il problema di un incremento della attuale produzione sì da coprire l’imminente prossimo buco lasciato dalle scorte secondarie. Ma quanto uranio rimane in natura? In linea di principio potrebbe esservene tanto ma la disponibilità concreta è legata al suo grado di concentrazione nella roccia da cui lo si estrae, ergo al suo costo di estrazione. Attualmente, le Risorse Ragionevolmente Sicure ad un costo inferiore ai 40US$/Kg sono di 1.9 milioni ton mentre vi sono altre 640 mila ton ad un costo tra i 40 e gli 80US$/Kg . Oltre queste quantità si entra nel regno del condizionale e dell’ipotetico. Dunque, all’attuale tasso di consumo l’uranio effettivamente disponibile durerebbe circa 38 anni. Se si dovesse aumentare il numero di reattori in esercizio senza un’effettiva garanzia sui rifornimenti di combustibile si butterebbero soldi al vento. Si rischierebbe di ultimare i lavori di costruzione dei reattori e di lasciar poi i medesimi spenti e inutilizzati. Naturalmente questi aspetti sono noti agli operatori del settore. Ma il costruire le centrali nucleari è, per alcuni, un business in sé. A prescindere dalla loro reale utilità economica e ambientale.

Solo il Canada dispone oggi di miniere nelle quali la concentrazione di ossidi di uranio è almeno dell’ 1% e la produzione nazionale di uranio copre il 30% del totale mondiale. L’Australia ha le riserve minerarie certamente più vaste ma di qualità peggiore del Canada in quanto in esse il grado di concentrazione è attorno a 0.1%. Al diminuire della concentrazione aumenta la massa di roccia da lavorare per estrarre una data quantità di uranio. Di conseguenza l’input energetico cresce rapidamente al diminuire del grado di concentrazione. Si stima che, al di sotto di una concentrazione dello 0.01%, il bilancio energetico diventi negativo in quanto l’input d’energia necessario all’intero e complesso processo produttivo è troppo alto. In sintesi, di uranio ce ne sarebbe ma estrarlo non converrebbe. Va inoltre ricordato che l’attività mineraria ha un alto impatto ambientale e, se si dovessero considerare (come sarebbe giusto fare in una corretta analisi del ciclo di vita) i costi ambientali indotti dall’intero processo estrattivo, i reali costi finali sarebbero ben maggiori di quelli sopra citati. Nell’intero ciclo di preparazione dell’uranio, il processo dell’ arricchimento è particolarmente energivoro: esso consiste nell’aumentare artificialmente la percentuale relativa del tipo di uranio più radioattivo rispetto alla percentuale che è data in natura. In molti impianti di arricchimento l’energia necessaria è prodotta bruciando carbone e dunque il contributo all’emissione di gas serra è non trascurabile. In generale, la stessa attività di costruzione degli impianti, dei reattori e il loro decommissionamento finale richiede grandi quantità di cemento la cui produzione è notoriamente inquinante e produttrice di diossido di carbonio. Le quantità di diossido di carbonio prodotte dall’intero ciclo associato al reattore nucleare aumentano al diminuire della percentuale di ossidi di uranio nella roccia. Per concentrazioni inferiori a 0.01%, le emissioni di CO_2 dovute ad una centrale nucleare diventano addirittura maggiori di quelle emesse da una centrale a metano a parità di energia prodotta. L’affermazione, spesso ripetuta, che l’energia nucleare è amica del clima è dunque oggettivamente falsa anche se, a tutt’oggi, un reattore nucleare inquina certo meno di una centrale a carbone.

Fonte: Marco Zoli

(1 - continua)

lunedì 14 luglio 2008

Costigliole d'Asti Paese "Riciclone"

(da la Repubblica.it)

(da la Repubblica.it)

I piccoli comuni battono le grandi città nel riciclo dei rifiuti. Lo dice la classifica stilata da Legambiente. E', infatti, Costigliole D'Asti, una località piemontese di soli 6.000 abitanti, a vincere il titolo di "Comune Riciclone 2008". Al secondo e terzo posto si collocano rispettivamente Bozzolo (piccolo comune mantovano) e Ziano di Fiemme in Trentino, tutti paesi del Nord Italia. Al Sud, invece, sorprende il miglior piazzamento di un paese campano. Si tratta di Bellizzi in provincia di Salerno.

La top ten di Legambiente arriva alla quindicesima edizione. Il particolare riconoscimento è destinato a quei centri che nell'ultimo anno si sono distinti nella gestione dei loro rifiuti.

Se la situazione dei piccoli centri si presenta abbastanza positiva, lo stesso non si può dire per le grandi città italiane. Torino, l'unica classificata nel 2007, è stata esclusa perché non ha raggiunto la soglia minima percentuale di raccolta differenziata, fermandosi al 38,8% di RD. Per entrare nella annuale classifica, infatti, i centri più grossi hanno dovuto centrare l'obiettivo del 40% nell'anno 2007, mentre per i comuni al di sotto dei 10.000 abitanti è stato imposto il superamento della soglia del 55%.

I parametri stabiliti dalla giuria hanno consentito a ben 1081 comuni di entrare nella classifica. Tra questi 968 si trovano al Nord, 42 al centro e 71 al Sud, di cui 39 solo in Campania.

Dai dati sulle regioni emerge lo strapotere di quelle settentrionali. Nella graduatoria spopolano Veneto, Trentino e Lombardia. Il Veneto, in particolare, si riconferma la regione più virtuosa con il 56% dei comuni ricicloni e con quattro centri tra i primi dieci classificati. In valore assoluto, però, è ancora la Lombardia a farla da padrona, con 364 comuni attivi nel riciclo della spazzatura.

domenica 13 luglio 2008

E' pulita l'energia del ballo

(da la Repubblica.it)

Danzare per salvare il pianeta. Illuminare a giorno in piena notte per risparmiare energia. Il paradosso arriva da Londra, dove l'altra notte è stata inaugurata la prima discoteca ecosostenibile al mondo. Habuna particolare pista da ballo: muoversi sul suo pavimento, e a maggior ragione dimenarsi come potrebbe fare un ballerino hip-hop, mette in azione un meccanismo che produce elettricità.

Surya, non a caso, è la suprema divinità del sole induista: e il locale, che ha aperto i battenti di recente, sfrutta anche energia solare e turbine eoliche. Ma la fonte prima è data dalla quantità di moto prodotta dalle danze dei clienti: capace, secondo il proprietario del locale, che si fa chiamare "Dr. Earth" (Dottor Terra), di assicurare il 60 per cento delle necessità di un ambiente per sua natura esoso sotto il profilo dei consumi energetici.

Il pavimento della zona adibita al ballo, infatti, è costituito di particolari cristalli. "Quando gli ospiti si muovono - spiega "Dr. Earth", i cristalli vengono pressati l'uno sull'altro: ciò genera corrente e che dà energia agli impianti di illuminazione e al sistema di climatizzazione". Il meccanismo è quello della piezoelettricità: particolari cristalli e materiali ceramici sono infatti in grado di generare energia in risposta alla pressione fisica.

Le tre forme di energia pulita, piezoelettrica, eolica e solare, prodotte per il locale sono in grado, nel loro insieme, di rifornire di corrente elettrica, stando al proprietario, un numero variabile da 14 a 20 utenti privati della zona. "Siamo la prima azienda al mondo che regala energia'', dice 'Dr Earth'. Ma non è tutto: tutto il locale è progettato all'insegna del risparmio, del riciclo, della tutela dell'ecosistema e chi è sensibile alle problematiche ambientali trova altre sorprese. Al bar si trova birra biologica, mentre sugli schermi al plasma scorrono messaggi diretti alle coscienze: "Ogni 10 secondi muore un bimbo a causa della fame", "ogni anno più di 200.000 acri di foresta pluviale vengono bruciati". E nei bagni, ogni volta che si opta per lo scarico "al risparmio", un monito informa l'utente che schiacciare un pulsante anziché l'altro fa risparmiare fino a 400 litri d'acqua al giorno. Ancora, pareti prodotte e arredate con materiali naturali, come olio di lino, resina e soda, o riciclati: giornali, lattine di soft drink, penne biro ricomposte a creare effetti artistici sui muri e sugli arredi. Chicca finale, ingresso libero garantito a chiunque arriverà a piedi, in bicicletta o utilizzando mezzi pubblici.

Ma molti sollevano più di una perplessità sul valore dell'iniziativa, sulla stessa capacità di un locale come questo di mantenersi autosufficiente, con le sole forze dell'energia "pulita", nel medio e nel lungo termine. "Non so se tutto questo sarà ancora in vita fra qualche mese, aspettiamo e giudicheremo - ha dichiarato Joseph Oliver, che lavora per la Commissione dello sviluppo sostenibile della capitale britannica". Dubbi che si ingigantiscono di fronte al presunto valore propedeutico dell'iniziativa, enfatizzato dal "Dottor Terra" che durante la faraonica inaugurazione, ha ipotizzato che il "Surya" possa contribuire a sensibilizzare i giovani verso le problematiche dell'ambiente.

Quale che sia l'esito dell'"esperimento" londinese, è già certo non resterà episodio isolato. A Rotterdam è in dirittura d'arrivo il WATT, locale che aprirà a settembre. E, a dirla tutta, sarà, secondo il Sustainable Dance Club cui fa capo, il primo vero locale notturno ecosostenibile...

mercoledì 9 luglio 2008

G8 e clima

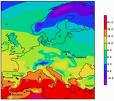

Si aperta oggi in Giappone la terza giornata del G8, il summit tra gli otto capi di Stato dei paesi più industrializzati. In agenda la questione del mutamento climatico, che vede la partecipazione al vertice dei leader delle otto principali economie emergenti: India, Cina, Brasile, Messico, Sudafrica, Australia, Indonesia e Corea del Sud. L’impegno del G8 sul clima non ha infatti alcuna possibilità di successo senza l’adesione delle altre grandi potenze come Cina e India.

Si aperta oggi in Giappone la terza giornata del G8, il summit tra gli otto capi di Stato dei paesi più industrializzati. In agenda la questione del mutamento climatico, che vede la partecipazione al vertice dei leader delle otto principali economie emergenti: India, Cina, Brasile, Messico, Sudafrica, Australia, Indonesia e Corea del Sud. L’impegno del G8 sul clima non ha infatti alcuna possibilità di successo senza l’adesione delle altre grandi potenze come Cina e India.Tutti d’accordo dunque sul senso politico della questione di fondo: il riscaldamento del pianeta è un'emergenza da affrontare attraverso «profondi tagli» delle emissioni al più presto. Ma si tratta di un accordo minimo, che non prevede nè cifre nè scadenze e che rimanda tutto al negoziato sul clima in sede Onu e alla prossima Conferenza di Copenahgen del novembre 2009 che dovrà disegnare gli scenari post-Kyoto per la lotta al Co2.

In sostanza, nonostante gli sforzi della presidenza giapponese del G8, Cina ed India hanno respinto gli accordi di programma rappresentati dal documento di ieri sul clima, che prevedeva l’impegno a dimezzare le emissioni per il 2050. Nel testo diffuso oggi dopo la cosiddetta riunione «Mem» tra gli Otto Grandi e le otto principali economie emergenti, non c’è un solo riferimento temporale al 2050, così come mancano totalmente cifre di riferimento.

I Paesi emergenti sottolineano che la possibilità di raggiungere questi obiettivi di lungo termine dipende anche da «tecnologie economiche innovative e più avanzate», e chiedono quindi una forte «cooperazione tecnologica con trasferimento di conoscenze avanzate». Naturalmente nel documento si riconosce che uno sforzo di queste dimensioni per abbattere le emissioni «richiederà una più grande mobilitazione di risorse finanziarie sia nazionali che internazionali».

Nell’affermare che le nuove tecnologie hanno un ruolo «cruciale» nella sicurezza energetica e nella lotta al cambiamento climatico, gli "otto più otto" intendono «promuovere» l’utilizzo di tali tecnologie, ed in particolare quelle «rinnovabili», quelle «pulite e a bassa emissione di carbone» e «per chi sia interessato», a promuovere l’uso «dell’energia nucleare», come ha sollecitato il premier italiano Silvio Berlusconi, concordando inoltre, durante la riunione, di ripetere l’incontro al summit G8 del prossimo anno in Italia.

La «visione comune sul clima» non ha però soddisfatto gli esperti: «C’è una seria omissione nel non aver fatto mezione dell’Action Plan di Bali che sollecita decisi tagli alle emissioni entro il 2020» ha detto Rajendra Pachauri presidente dell’Intergovernamental Panel on Climate Change, Ipcc nonchè premio Nobel 2007 per la pace insieme ad Al Gore. «Secondo James Hansen poi, responsabie del Nasa Goddard Institute for Space Studies di New York, gli Otto «non hanno capito il problema» e hanno preso misure «e garantiranno ai nostri figli solo catastrofi climatiche».

Casa sicura 1

L'analogia tra gli elementi di un edificio e quelli del corpo umano è sorpendente. La struttura di un edificio ne assicura il sostegno così come lo scheletro per il corpo umano; in un edificio di recente costruzione la struttura è costituita da una ossatura in cemento armato o acciaio, mentre in un edificio vecchio è costituita dai muri portanti e dalle travi.

L'analogia tra gli elementi di un edificio e quelli del corpo umano è sorpendente. La struttura di un edificio ne assicura il sostegno così come lo scheletro per il corpo umano; in un edificio di recente costruzione la struttura è costituita da una ossatura in cemento armato o acciaio, mentre in un edificio vecchio è costituita dai muri portanti e dalle travi.

Gli impianti di riscaldamento, elettrico, idraulico e del gas somigliano molto agli apparati del corpo umano, come quello respiratorio, circolatorio, digerente. Le pareti di tamponamento corrispondono alla muscolatura, che dà forma e irrobustisce il corpo. I rivestimenti, l'intonaco e la tinteggiatura hanno una funzione analoga alla pelle, elemento protettivo del corpo. Le riunioni di condominio dovrebbero esserne il cervello.

Come nell'uomo le malattie si manifestano con sintomi come la febbre, il pallore e i dolori, così negli edifici lesioni, muri inclinati, solai avvallati, materiali che si sgretolano e macchie di umidità devono essere considerati campanelli d'allarme. L'analogia con il corpo umano è utile anche per una migliore comprensione e classificazione dei difetti e dei danni che si possono riscontrare nell'edificio e che possono essere raggruppati in:

- difetti dei materiali da costruzione

- difetti di funzionamento e di manutenzione

- danni dovuti a traumi e a invecchiamento

Come i medici in base ai sintomi risalgono alla malattia, architetti, ingegneri e tecnici, dalle manifestazaioni anomali e dalle alterazioni visibili della forma di un edificio, sono in grado di risalire alle cause che le hanno determinate. Come i medici dispongono oggi di una serie di strumenti e apparecchiature per individuare la natura e seguire il decorso di una malattia, così i tecnici hanno messo a punto analoghi mezzi di indagine e misura che permettono di riconoscere e monitorare nel tempo l'evoluzione di una manifestazione di dissesto, ovvero della malattia dell'edificio.

sabato 5 luglio 2008

Technotown

Pochissimi di voi passeranno per Roma quest'estate. Ma se vi succedesse io penserei ad una visita aTechnotown.

Pochissimi di voi passeranno per Roma quest'estate. Ma se vi succedesse io penserei ad una visita aTechnotown.

Letture scientifiche, installazioni interattive, giochi ed attività da vivere dentro e fuori Technotown, la ludoteca dedicata alle nuove tecnologie di Villa Torlonia. Technotown, infatti, partecipa all'iniziativa "Musei d'estate", iniziativa del Comune di Roma e di Zètema Progetto Cultura.

All'esterno della struttura, ad esempio, i ragazzi potranno cimentarsi con Sbong!, il gioco interattivo che rivisita virtualmente uno dei primi videogiochi degli anni ’70, nel quale è fondamentale la collaborazione con la propria squadra per coordinare i movimenti e colpire la palla virtuale. Per tutta l’estate sarà possibile giocare all’aperto e ogni venerdì squadre di bambini, ragazzi e famiglie potranno sfidarsi in un vero torneo. Sempre all'aperto si potrà visitare la Serra della creatività, e lì scoprire i materiali del futuro, osservare il mondo attraverso una termocamera ed entrare nell’universo della robotica.

Da non perdere il pavimento musicale, si potrà diventare presentatori per una sera oppure girare un video clip come una vera band musicale.

Ogni giorno della settimana sarà incentrato su una diversa attività:

il martedì (ore 19 e ore 20) i ragazzi potranno partecipare al laboratorio di Robotica con LEGO Mindstorms dove ognuno potrà costruire e programmare il suo robot “LEGO Mindstorms” applicando un uso completamente nuovo dei celebri mattoncini;

il mercoledì (ore 19.00 e ore 20.00) potranno giocare alla Caccia al tesoro palmare in cui, con l’aiuto di palmari e di un satellite GPS, i partecipanti correranno verso la meta senza il rischio di perdersi;

il giovedì (ore 19.00 e ore 20.00) entreranno nel Technolab, uno spazio dedicato a laboratori scientifico - teconologici realizzati con attrezzature multimediali;

tre venerdì estivi sarà la volta delle Conferenze spettacolo

11 luglio ore 21.00 Cielo di notte: si guarda o si vede? a cura di Paco Lanciano

18 Luglio ore 21.00 Bolle di sapone: arte, scienza, fantasia a cura di Michele Emmer

5 settembre ore 21.00 Piccolo corso per apprendisti astronomi a cura del Planetario di Roma.

E' previsto un percorso breve (3 sale) al prezzo di 4 euro e uno lungo(laboratori e giochi) al costo di 6 euro.

Technotown - via Spallanzani 1a - Villa Torlonia - Info: 060608

Estate a Technotown

da 01 lug 2008 a 13 set 2008

giovedì 3 luglio 2008

Cosa è l'URL?

In questo articolo vedremo cos'è un URL, da quali parti è composto e cosa sono gli URL assoluti e relativi. Forse vi può sembrare banale come argomento, ma in effetti sono molti gli utenti della rete che digitano in maniera automatica un indirizzo web nella barra degli indirizzi del proprio browser senza sapere cosa ci sta dietro. Ed ancora peggio, fra questi utenti, ci sono anche quelli che realizzano pagine e siti web senza sapere cos'è un URL.

In questo articolo vedremo cos'è un URL, da quali parti è composto e cosa sono gli URL assoluti e relativi. Forse vi può sembrare banale come argomento, ma in effetti sono molti gli utenti della rete che digitano in maniera automatica un indirizzo web nella barra degli indirizzi del proprio browser senza sapere cosa ci sta dietro. Ed ancora peggio, fra questi utenti, ci sono anche quelli che realizzano pagine e siti web senza sapere cos'è un URL.

Un URL (Universal Resource Locator) è un indirizzo in un formato specifico che può identificare in modo univoco la posizione di un oggetto sul web. In sostanza un URL è come un sofisticato indirizzo o numero di telefono, con il quale si dice al browser (il programma di navigazione su internet: internet explorer, mozilla firefox ecc.) esattamente dove trovare un particolare oggetto nella rete. Un URL ha una sintassi molto semplice, che nella sua forma normale si compone di tre parti:

tiposerver://nomehost/nomefile

- La prima parte indica con una parola chiave il tipo di server a cui si punta:può trattarsi di un server http, di un server ftp, di un server telnet e così via;

- La seconda parte indica il nome simbolico dell'host su cui si trova il file indirizzato;

- La terza parte indica nome e posizione del singolo documento o file a cui ci si riferisce.

Tra la prima e la seconda parte vanno inseriti i caratteri '://'.

Analizziamo ad esempio l'url http://www.melevisione.rai.it/index3.htm:

- La parola chiave 'http' indica che ci si riferisce ad un server web; http è il protocollo usato dal browser per richiedere un file ad un server web.

- L'host è ww.melevisione.rai.it; si tratta del nome del server che contiene l'oggetto richiesto. Molti browser accettano anche la parte host da sola senza specificare http. Ricordate però che si tratta semplicemente di un'abbreviazione da parte del browser e non di un vero e proprio url.

- Infine index3.htm è il nome del file che si trova nel server e che vogliamo che ci venga inviato.

martedì 1 luglio 2008

Prospettive tecnologiche dell'energia

Presentato oggi a Roma dall'ENEA il rapporto 'Le Prospettive tecnologiche nell'energia', lo scenario realizzato dall'Agenzia Internazionale dell'Energia per conto del G8. Secondo le stime del rapporto, se non si corre subito ai ripari con una ''rivoluzione dell'energia'', nei prossimi 40 anni invece che liberarci dalla schiavitu' del petrolio ne useremo il 70% in piu', e le emissioni mondiali cresceranno del 130%.

Presentato oggi a Roma dall'ENEA il rapporto 'Le Prospettive tecnologiche nell'energia', lo scenario realizzato dall'Agenzia Internazionale dell'Energia per conto del G8. Secondo le stime del rapporto, se non si corre subito ai ripari con una ''rivoluzione dell'energia'', nei prossimi 40 anni invece che liberarci dalla schiavitu' del petrolio ne useremo il 70% in piu', e le emissioni mondiali cresceranno del 130%. Il Presidente dell'Enea Paganetto, durante la presentazione ha fatto saper che 'il rapporto conferma quanto l'ENEA ha gia' piu' volte evidenziato nella presentazione dei propri programmi di ricerca, ovvero che l'accelerazione dello sviluppo delle tecnologie per l'energia e' la chiave per affrontare le sfide della crescente domanda di energia e della riduzione delle emissioni climalteranti'

Nell'Ambito del suo intervento Paganetto ha dichiarato che 'occorre realizzare una vera rivoluzione tecnologica nel modo di produrre e consumare energia, con lo sviluppo di un sistema di trasporti a zero emissioni, insieme a un massiccio ricorso alle fonti rinnovabili, all'energia nucleare, alla riduzione degli sprechi energetici.

Nel rapporto sono esposti anche due scenari possibili per una rivoluzione dell'energia, il primo chiamato 'Act', prevede che sfruttando tecnologie in gran parte gia' esistenti si possono riportare le emissioni di CO2 nel 2050 ai livelli di oggi, con un costo totale di 17 mila miliardi di dollari. Il secondo scenario invece denominato 'Blue' prevede l'utilizzo di tecnologie la maggior parte ancora da sviluppare per avere nel 2050 meta' delle emissioni rispetto a oggi, ma con una spesa prevista di 45 mila miliardi di dollari.